O teste A/B enganoso é simples

por Rostyslav Mykhajliw Fundador da TrueSocialMetrics.com ~ 5 min

Clássico

O teste A/B clássico é uma distribuição entre diferentes estados. Vamos começar com uma amostra geral que todos usam. Temos um site com um botão de cadastro, atualmente é azul, mas queremos testar uma nova cor vermelha.

Em seguida, alocamos algum tráfego para lá e esperamos algum. Há uma calculadora simples para statistical significance.

Opção A: 50 mil visitantes - 500 inscrições Opções B: 50 mil visitantes - 570 inscrições - vencedor

B é um vencedor, é claro. Mais inscrições, significância estatística.

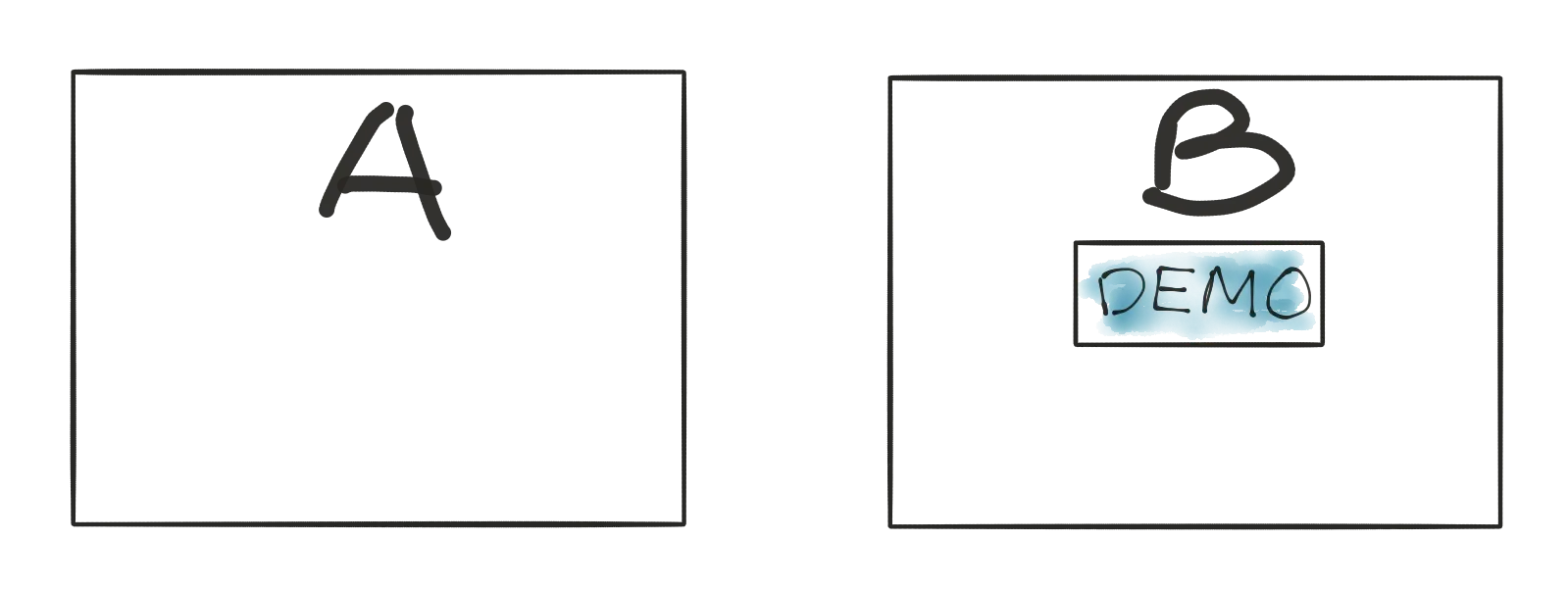

Um novo clássico da maçã às laranjas

Espere um pouco! O que estamos lançando é algo novo. Por exemplo, estamos adicionando um botão “demo” para uma visão geral do guia passo a passo do produto.

Se seguirmos uma lógica simples de testes A/B - não funciona! Porque não podemos comparar maçãs com laranjas. Não podemos comparar nada a alguma coisa! Está totalmente incorreto. Se não houver um botão de demonstração, os usuários podem ter uma experiência pior do que aqueles que têm essa opção. Mas esta opção pode ajudar apenas os usuários que já se interessaram pelo produto ou já declararam usar o produto recentemente. Mesmo que você tenha milhões de tráfego, você não pode dizer como funciona em algumas horas/dias porque os resultados podem ser adiados no tempo.

Para uma nova funcionalidade deve ser liberado de forma linear conforme processo de liberação enteral. Só então depois de algum tempo podemos olhar para isso e descobrir se teve algum impacto na experiência do cliente ou não, mas acompanhando as métricas de negócios. Os testes A/B NÃO são aplicáveis a uma nova funcionalidade.

AA/BB testa a confiança

Volte para a primeira amostra com o botão de inscrição. Se nosso palpite estiver correto, podemos adicionar mais opções A e mais opções B e nada mudou, porque B ainda pode vencer a batalha.

Então veja os resultados:

A1: 50 mil visitas - 500 inscrições A2: 50 mil visitantes - 580 inscrições - vencedor B1: 50 mil visitantes - 570 inscrições - vencedor B2: 50 mil visitantes - 500 inscrições

O QUE! O QUE! O QUE! Você pode dizer que é impossível, mas esta situação mostra diferença se a alocação de visitantes entrar em vigor nos resultados dos testes. E esses resultados estão mostrando significância estatística estável de 95%, mas baixa confiança.

Teste adaptativo

Se voltarmos ao início do artigo, veremos um enorme tráfego de 50 mil visitantes e 500 transições necessárias para receber resultados significativos. No entanto, nem todas as páginas têm esta possibilidade. Nem todas as startups são boas o suficiente para gerar esse tráfego, ou podem ser páginas de baixo tráfego, como configurações/cobranças, etc. Para todos esses casos, os testes a/b clássicos levarão muito tempo para coletar dados meses/semestre do ano ou então. A próxima desvantagem da abordagem geral é que pelo menos 50 mil visitantes (de 100 mil alocados para teste) pioraram a experiência do cliente. Então, estamos esperando muito tempo e perdendo clientes devido à alocação para um teste de “perda”. Isto faz algum sentido ? Na saúde os médicos cruzavam as questões dos casos, mas numa mesa estava a vida das pessoas. Se fizermos um teste durante o qual 50% dos pacientes estão morrendo devido a “ainda não testados”. E é uma loucura. Aqui está um cara, Marvin Zelen, que teve a ideia do teste adaptativo, chamado agora Zelen’s design.

Em palavras curtas

Vamos imaginar que temos 2 possibilidades: bolas vermelhas e azuis, então estatisticamente é 50% de probabilidade.

Por exemplo, alocamos aleatoriamente o visitante para “azul” e “azul” é uma experiência melhor porque conseguimos uma compra. Neste caso, “azul” está ganhando, é por isso que adicionamos uma bola “azul” extra à piscina.

Como resultado, a probabilidade mudou "vermelho" - 33% e "azul" - 67%

Parece bom! Mas o próximo visitante com “azul” não faz nada. Então “azul” está perdendo, é por isso que temos que remover uma bola “azul” da piscina e voltamos ao nosso estado anterior.

Vantagens: + funciona para pequena quantidade de tráfego + de forma adaptativa oferece melhor atendimento aos usuários Pontos negativos: - requer que os desenvolvedores trabalhem para descobrir ganhar/perder testes no processo de teste

Concussões

- O teste A/B clássico não funciona para novos recursos porque você não pode testar nada com algo

- Normalmente, os testes A/B NÃO são representativos, mesmo que sua análise diga que são

- A abordagem AA/BB ajuda a verificar os resultados do teste A/B

- O teste adaptável é super útil para tráfego pequeno, mas requer trabalho manual para definir metas

Quando você está pronto para balançar suas análises de mídia social

TrueSocialMetrics dar uma tentativa!

Iniciar teste

Nenhum cartão de crédito necessário.